Como a computação in-memory mudará o paradigma da obtenção de informações em tempo real

Chegamos ao quinto artigo da nossa série A Revolução dos sistemas de gestão imposta pela Omniera e, agora, vamos tratar de computação in-memory e suas vantagens na obtenção de informações em tempo real.

Nos artigos anteriores dessa série, já falamos sobre as principais transformações causadas por essa revolução, o advento da economia colaborativa, a aplicabilidade do Big Data nos negócios da Omniera e sobre os impactos da Internet das Coisas sobre a gestão de empresas.

Introdução

Computação in-memory refere-se à arquitetura que carrega completamente os bancos de dados para a memória, de forma que se possa obter acesso muito mais rápido a grandes quantidades de informações. A computação in-memory ganhou importância, principalmente, porque elimina os requisitos de disco (I/O) – I/O refere-se ao input e output, leitura e gravação das informações em discos rígidos.

A computação in-memory elimina, também, os requisitos de transações ACID dos bancos de dados. Uma transação de banco de dados refere-se a uma sequência de operações executadas como uma única unidade lógica de trabalho. Uma unidade lógica de trabalho, por sua vez, deve mostrar quatro propriedades, designadas pelas iniciais ACID – Atomicidade, Consistência, Isolamento e Durabilidade, para que seja qualificada como uma transação.

Ao eliminar requisitos de transação ACID, que estão incluídas no processamento de transações on-line para aplicativos OLTP – Online Transaction Processing ou em português Processamento de Transações em Tempo Real – a computação in-memory torna possível que uma grande massa de dados armazenada na nuvem, por exemplo, seja processada muito rapidamente.

Para tornar a computação in-memory viável, os sistemas gerenciadores de banco de dados (SGBD) passaram por transformações e, dessas, surgiu o IMDB – In-Memory Database. A tecnologia IMDB tem sido apontada como a solução para problemas de desempenho de banco de dados por ser capaz de carregar e executar todos os dados de uma base de dados grande na memória. Isso remove uma quantidade considerável de inputs e outputs (I/O) que onerava as chamadas e criava problemas de desempenho com sistemas de banco de dados.

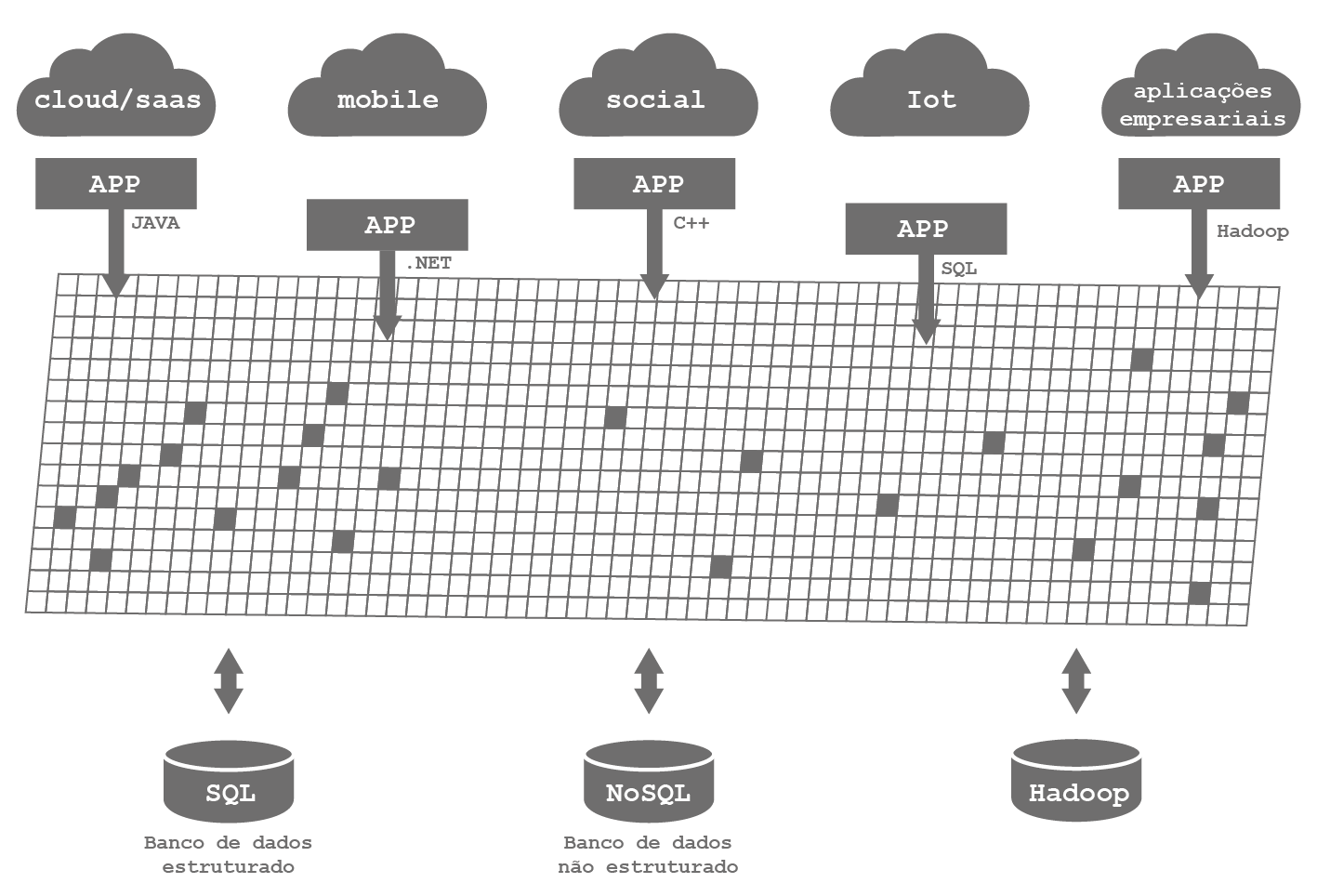

Figura – Computação in-memory

A computação in-memory só tornou-se viável, também, por conta da constante evolução da arquitetura de hardware. Três décadas atrás, as empresas que queriam adotar um sistema ERP só podiam contar com os gigantescos e caríssimos computadores mainframe que tinham um custo de processamento imenso e fora do alcance comercial para a maioria das empresas. Com a invenção do microchip e mudanças significativas na arquitetura de hardware e software, a adoção de um sistema ERP se popularizou.

Evolução no modelo de armazenamento de dados

Segundo dados da pesquisa The Internet Economy 25 years after .com, de Robert Atkinson, publicados no Information Technology and Innovation Fundation em março de 2010, no ano 2000, o armazenamento de um gigabyte em disco rígido custava em torno de 44 dólares e, em 2010, um gigabyte armazenado em um disco rígido já custava apenas sete centavos de dólar.

O primeiro computador comercializado em massa no mundo, o IBM 1401, lançado em 1959, media 1,50 metros de altura, 90 centímetros de largura e 4.096 bits de memória. Ele podia executar, há época, 193 mil somas de números de oito dígitos em um minuto.

Esse computador era comercializado através de leasing no valor de 30 mil dólares por ano de utilização. Em 2012, no entanto, o computador mais barato do mundo, o Raspeberry Pi, custava 25,34 dólares. Os atuais smartphones que cabem no bolso, conectam à internet através de dados móveis ou redes wifi custando algumas centenas de dólares tem capacidades de armazenamento e processamento infinitamente superiores ao supercomputador CRAY-1A lançado pela Cray Research na década de 1970. O CRAY-1A pesava perto de cinco toneladas e custava algo em torno de nove milhões de dólares.

Sistemas ERP com tecnologia In-memory

As empresas que tem o mesmo sistema ERP há mais muitos anos conhecem bem as dificuldades para gerenciar imensas bases de dados e extrair informações históricas e análises de tendência a partir dessas bases de dados que utilizam conceitos tradicionais de armazenagem e extração de dados.

Durante décadas, para rodar processos que exigem muito processamento e acessam grandes massas de dados, os fornecedores de sistemas ERP criavam rotinas noturnas, rotinas de segundo plano e rotinas que eram executadas em dias não úteis para consolidar informações estratégicas para as empresas.

Caso uma empresa precisasse de uma informação diferente da que estava planejada nessas rotinas, não teria fácil acesso a ela. Por isso, cada vez mais as questões de desempenho para busca e extração de informações históricas e análises de tendência tornaram-se preponderantes para o sucesso das organizações.

Nesse contexto, alguns fornecedores de sistemas ERP já prepararam seus produtos para combinar tecnologias da computação em nuvem com a computação in-memory, criando soluções que oferecem hardware, storage, sistema operacional, software de gerenciamento e recurso de busca de dados in-memory, fazendo com que os dados a serem processados fiquem na memória RAM em vez de serem lidos a partir de discos ou de armazenamento flash, proporcionando aumento de performance.

A tendência é que esta nova geração de arquitetura seja aplicada à expressa maioria dos sistemas ERP e que, dentro de alguns anos, muitas empresas passem a se beneficiar dessa alternativa para ganhos expressivos de performance na busca de informações.

Como forma de apoiar o dinamismo e a diversificação dos mais diversos negócios, as empresas que estão adotando ou migrando de sistema ERP devem buscar uma solução baseada em uma plataforma inovadora, robusta, escalável e funcionalmente abrangente, que permita gerenciar todos os canais – solução Omnichannel e que combine a possibilidade de estar na nuvem com a agilidade fornecida pela computação in-memory.

Desde 2013, várias empresas estão adotando sistemas ERP com esse formato e proposta. Embora ainda não tenha ocorrido a consolidação dos sistemas ERP que adotam computação in-memory, fica evidente que essa solução é a mais racional para as companhias.

Migração para sistemas ERP preparados para a Omniera

Outro movimento interessante que já vem ocorrendo e que deve crescer nos próximos anos é a migração de sistemas ERP tradicionais e legados, nos quais a arquitetura não favorece as questões de desempenho e performance para lidar com grandes bases de dados, para sistemas ERP idealizados para a Omniera que estão aptos a lidar com a computação in-memory.

Antes de existir a possibilidade de subir e manter bases de dados expressivas em memória, muitas empresas faziam malabarismos incríveis, inclusive a exclusão de dados históricos para manter a performance de seus sistemas ERP razoáveis. Outros investiam verdadeiras fortunas em hardware, mas como a arquitetura do ERP estava baseada em bancos de dados transacionais, com a necessidade de I/O em disco e poucas opções de aumento da performance, esses investimentos não eram suficientes para suportar as necessidades de performance do negócio e ampliar a eficiência operacional.

Por outro lado, as soluções ERP in-memory tem elevado potencial analítico e arquitetura de alto desempenho, o que promete levar os usuários a explorar volumes elevados de informações com alto nível de detalhes em tempo real, de forma a garantir que as empresas que adotem tais soluções estabeleçam uma estrutura robusta, segura e ágil, que ao mesmo tempo simplifique seus processos internos e potencialize a tomada de decisão em diferentes níveis da organização.

Em um caso recente, uma empresa de vestuário – lingerie – optou por um ERP Omnichannel que adota computação in-memory. Agora, processos que demoram cerca de quatro horas em seu sistema ERP antigo passam a ser disponibilizados em segundos, demonstrando o ganho de desempenho que esses sistemas podem oferecer.

Publicado originalmente em: https://blog.vtex.com/pt/computacao-in-memory/